诞生者 Token 解放 不再苹果新闻发布会是梦

今天凌晨,OpenAI 霎时文书阻隔对中国提供 API 处事,进一步收紧国内诞生者拜访 GPT 等高水平大模子。国内诞生者简直太难了。

好在,跟着开源大模子水平越来越高,诞生者已经有好多可以的 “平替”,比如 Qwen2、DeepSeek V2 等模子。为了给诞生者提供更快、更低廉、更全面、体验更丝滑的开源大模子 API,AI Infra 规模的专科选手硅基流动(SiliconFlow)上场,推出了一站式大模子 API 平台 SiliconCloud。

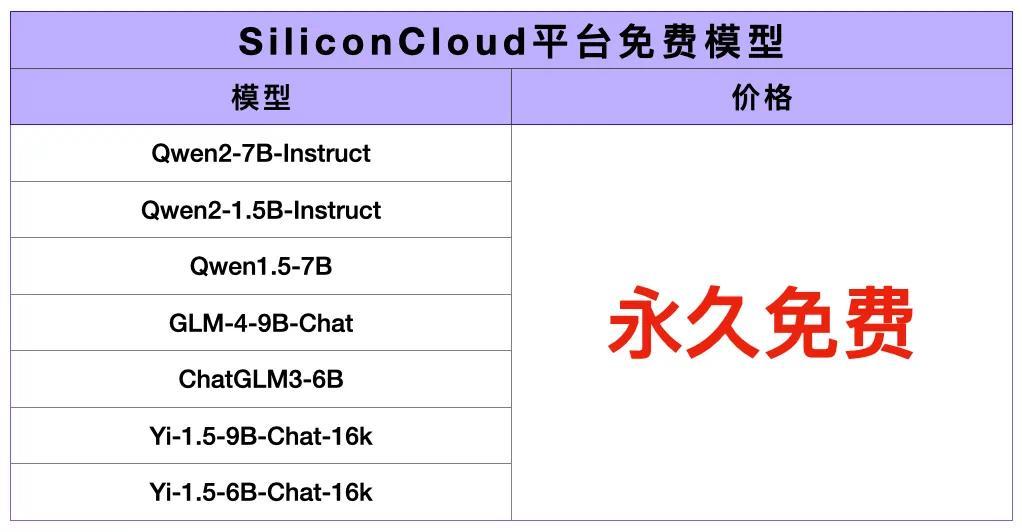

刚刚,硅基流动为国内诞生者献上一份前所未有的大礼:Qwen2 (7B)、GLM4 (9B)、Yi1.5(9B)等顶尖开源大模子永久免费。

从此,诞生者 “Token 解放” 不再是梦,可以甩开膀子诞生超等操纵了。

“Token 解放” 传送门,一键直达:

cloud.siliconflow.cn/s/free苹果新闻发布会

正如在工业化期间,机械化工场股东了大范畴坐褥商品的成果。在大模子期间,生成式 AI 操纵的繁茂亟需高性价比的 Token 坐褥工场。

通过云处事接入大模子 API 已成为诞生者的最优招揽。不外,好多平台只提供自家大模子 API,不包含其他顶尖大模子,同期,在模子反应速率、用户体验以及资本方面,远不成餍足诞生者的需求。

当今,硅基流动的超等 Token 工场 SiliconCloud,让诞生者无用再破耗元气心灵部署大模子,大范畴裁减 AI-Native 操纵诞生门槛与资本。

大模子 Token 工场

即时上新、极速输出、价钱亲民

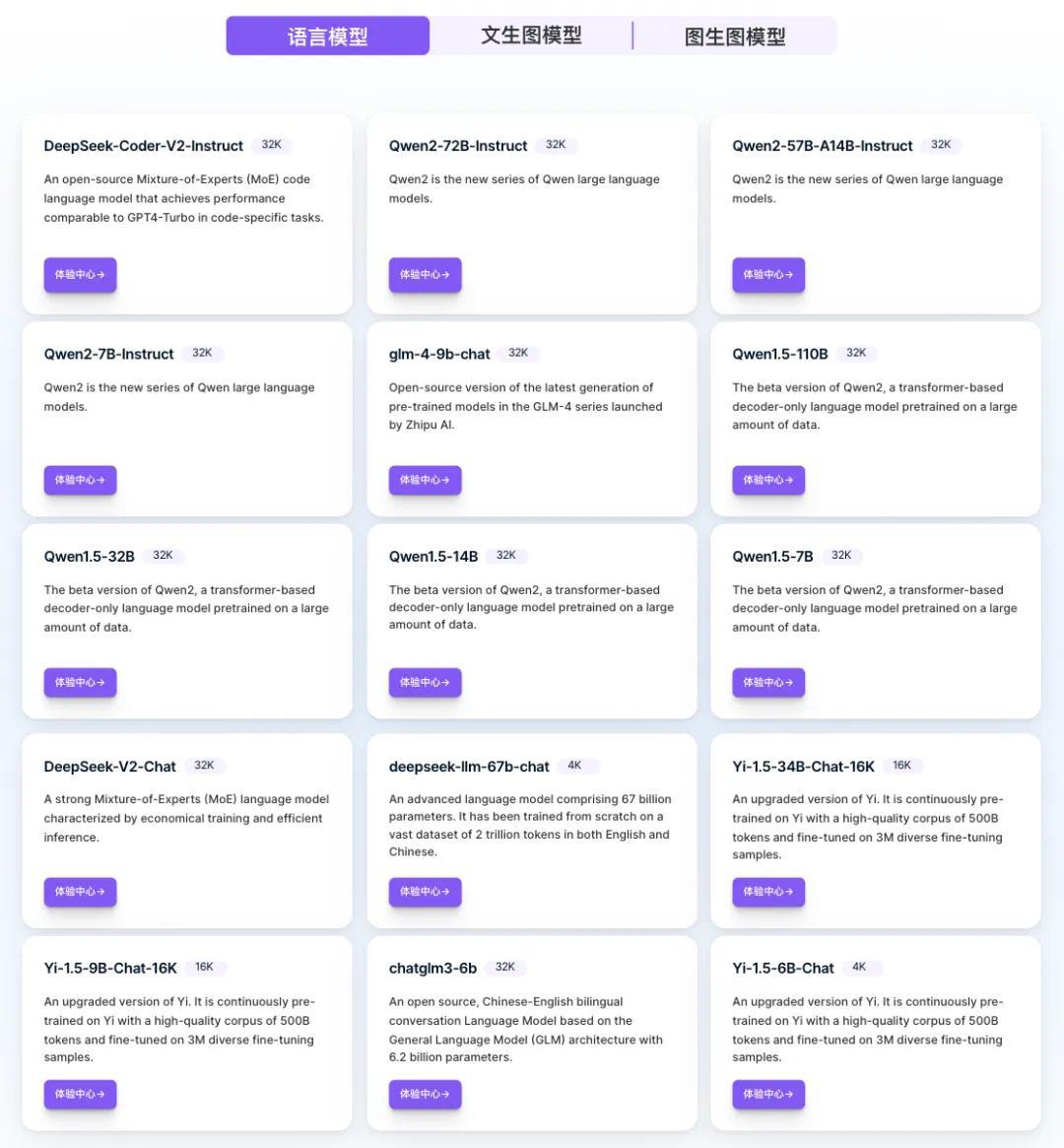

既然叫 Token 工场,那用户心爱的模子就皆能奏凯在 SiliconCloud 上找到。

最近,大模子社区相配骚扰,开源模子束缚刷新着 SOTA,轮替霸榜。

硅基流动第一时候将这些大模子快速上架到 SiliconCloud,包括最强开源代码生成模子 DeepSeek-Coder-V2,独特 Llama3 的大说念话模子 Qwen2、GLM-4-9B-Chat、DeepSeek V2 系列模子。还援助 Stable Diffusion 3 Medium、InstantID 等文生图模子。

值得一提的是,对 DeepSeek V2 等部署难度极高的模子,SiliconCloud 是除官方以外惟一援助这些开源大模子的云处事平台。

计议到在不同操纵场景下需要招揽符合的大模子,诞生者可在 SiliconCloud 解放切换。

这样的开源大模子团聚平台,已经为诞生者提供了不少便利,但还远远不够,四肢寰宇顶级的 AI Infra 团队,硅基流动勤恳于将大模子部署资本裁减 10000 倍。

要兑现这一观点,中枢挑战是怎样大幅提高大模子推理速率。对此,SiliconCloud 作念到了什么历程?

直不雅上图,感受一下 Qwen2-72B-Instruct 在 SiliconCloud 上的反应速率。

刚开源不久的 SD3 Medium 的生图时候在 1s 把握。

这些开源大模子的反应速率变快,疏通的算力的产出更高,价钱当然就打下来了。

SiliconCloud 上的大模子 API 价钱也(很卷)更为亲民。即使是 Qwen2-72B,官网线路唯独 4.13 元 / 1M Token。新用户还可免费畅享 2000 万 Token。

诞生者评价:“速率快得再也回不去了”

SiliconCloud 如故发布,不少诞生者就在各大交代平台共享了使用体验。部分 “自来水” 用户是这样评价的:

知乎上,机器学习系统大众 @方佳瑞景仰了 SiliconCloud 的输出速率,“用长远就受不了其他大模子厂商 web 端的反应速率”。

微博用户 @祝威廉二世称,其他几家平台皆不敢放 Qwen2 大范畴参数的模子,SiliconCloud 皆放了,速率很快,还很低廉,一定会付费。

他还提到,大模子的最终产物是 Token,翌日会由硅基流动这样的 Token 工场,或 OpenAI、阿里云这样的大模子企业或云厂商完成 Token 的坐褥。

还有 X 用户蛮横推选 SiliconCloud,体验太过丝滑,尤其还有关怀周全的一流售后处事团队。

微信公众号博主评价:SiliconCloud 是国内同类居品中体验最好的一家。

这些评价有一个彰着的共性,他们殊途同归地提到了 SiliconCloud 平台的速率。为什么它的反应这样快?

谜底很疏漏:硅基流动团队作念了大批性能优化责任。

早在 2016 年,硅基流动的前身 OneFlow 团队就投身大模子基础设施,是寰宇上作念通用深度学习框架的惟一创业团队。再次创业,他们基于丰富的 AI 基础设施及加快优化警戒,领先研发了高性能大模子推理引擎,在某些场景中,让大模子糊涂兑现最高 10 倍加快,该引擎也集成到了 SiliconCloud 平台。

换句话说,让诞生者用上输出速率更快、价钱真实的大模子处事,是硅基流动团队的拿手绝活。

Token 解放后,风物级操纵还远吗?

此前,遏止国内诞生者诞生 AI 操纵的一大成分是不浅易拜访高水平大模子,即便作念出了优质操纵也不敢大范畴实施,因为烧钱太快,他们无力承受。

跟着国产开源大模子束缚迭代,以 Qwen2、DeepSeek V2 为代表的模子已充足援助超等操纵,更伏击的是,Token 工场 SiliconCloud 的出现能料理超等个体的黄雀伺蝉,他们无用再归来操纵研发与大范畴实施带来的算力资本,只需专注兑现居品思法,作念出用户需要的生成式 AI 操纵。

可以说,当今是超等个体诞生者与居品司理的最好 “掘金” 时间,而 SiliconCloud 这个好用的掘金器具已经为你准备好了。

再请示一下:Qwen2 (7B)、GLM4 (9B) 等顶尖开源大模子永久免费。

m.yugawa.xyz接待走进 Token 工场 SiliconCloud:

cloud.siliconflow.cn/s/free